2025-08-25 23:04

2025-08-25 22:59

AI修复又一里程碑! 爱奇艺与上影技术厂联合共建“影绮AI实验室”

2025-08-25 22:54

“寻找原汁原味老字号”活动启动,抖音生活服务持续助力老字号焕新

2025-08-25 22:42

2025-08-25 22:40

苏见信 (信)「尽兴而活」成都站巡回演唱会圆满收官 苏有朋惊喜助阵引热潮

2025-08-25 22:08

学生专属特惠!仅需12元/月畅享爱奇艺《临江仙》《种地吧3》等海量精彩内容

2025-08-25 22:01

2025-08-25 21:59

2025-08-25 21:56

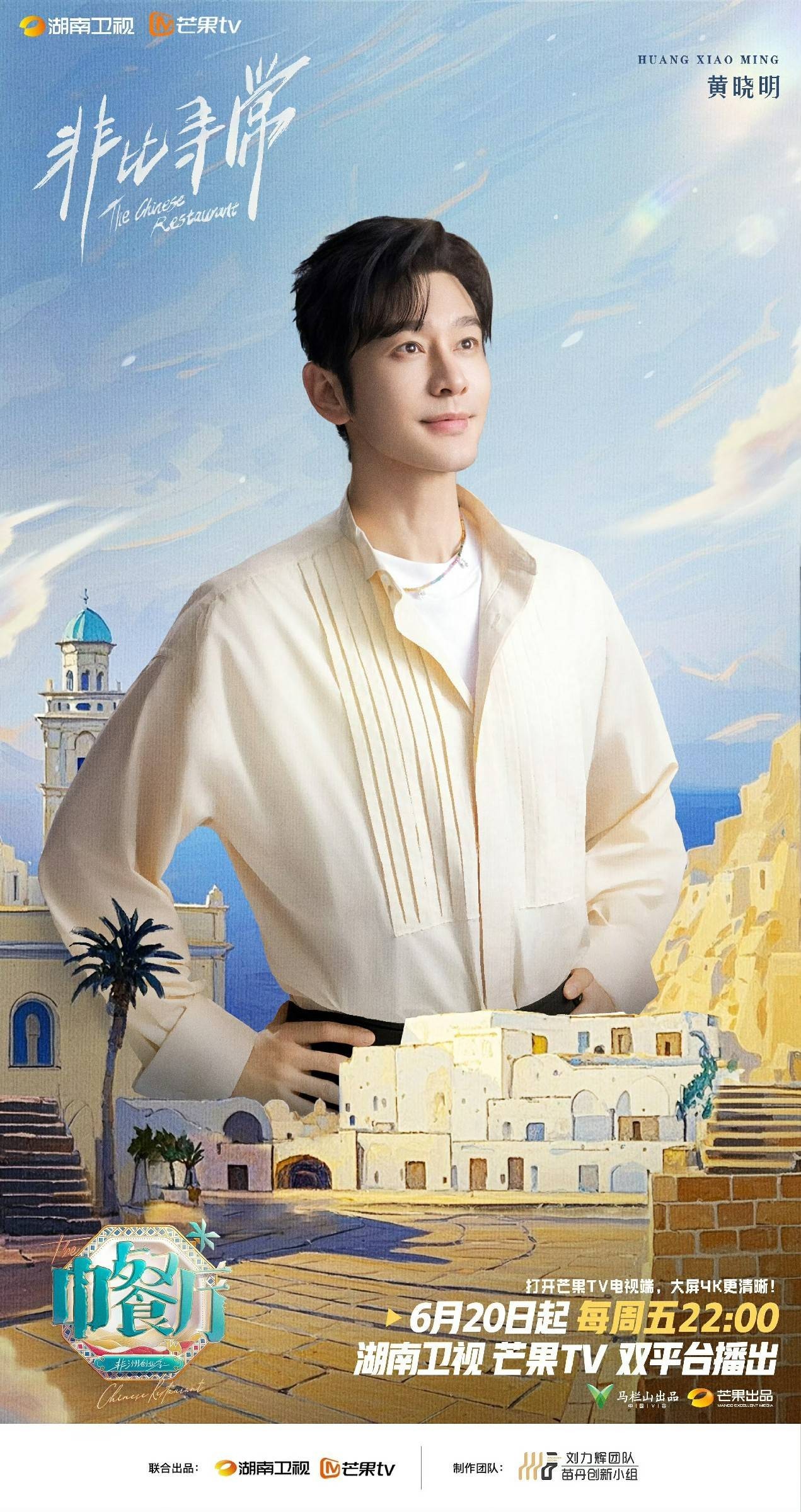

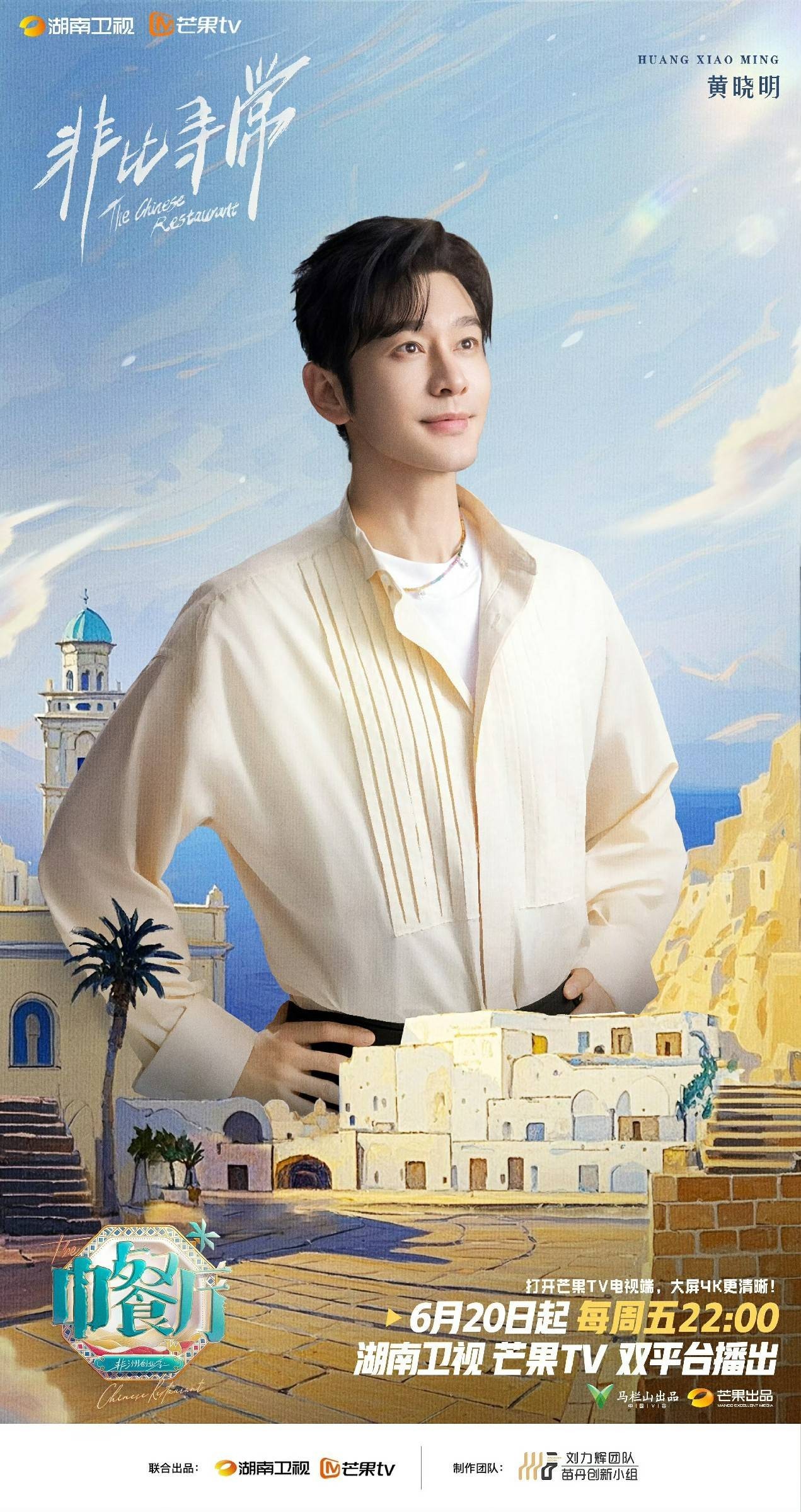

黄晓明率队开启《中餐厅·非洲创业季》新篇章,影视综多面开花诠释全能担当

2025-08-25 21:54

2025-08-25 21:46

2025-08-25 21:44

2025-08-25 21:42

第三届浪潮创作人论坛在京举行,共同探讨AI共创时代的创新音乐叙事

2025-08-25 21:37

2025-08-25 21:31

金鹰卡通《三孩来了 3》:唐九洲谈原生家庭,井胧助力萌娃传递爱意

2025-08-25 21:25

爱奇艺举办第五届“金豪笔编剧之夜” 62位编剧20部作品获表彰

2025-08-25 21:20

2025-08-25 21:17

2025-08-25 21:15

2025-08-25 21:11

2025-08-25 21:05

黄晓明率队开启《中餐厅·非洲创业季》新篇章,影视综多面开花诠释全能担当

2025-08-25 21:05

房东的猫「世界/青年」济南演唱会:在荷风泉城里演奏一曲青春音符的夏日回响

2025-08-25 20:56

2025-08-25 20:36

2025-08-25 20:29

在 AI 战场里拿掉英特尔,PC 能活吗?

在 AI 战场里拿掉英特尔,PC 能活吗?在 AI 战场里拿掉英特尔,PC 能活吗?

李静、刘璇共话新平衡之约

李静、刘璇共话新平衡之约李静、刘璇共话新平衡之约

折射一代中国制造人的拼搏与奋争 《淬火年代》再续“东海宇宙”创业奇迹

折射一代中国制造人的拼搏与奋争 《淬火年代》再续“东海宇宙”创业奇迹折射一代中国制造人的拼搏与奋争 《淬火年代》再续“东海宇宙”创业奇迹

李川张颜齐直播带货笑料频出! 姚尧再现春晚同款直播名场面!

李川张颜齐直播带货笑料频出! 姚尧再现春晚同款直播名场面!李川张颜齐直播带货笑料频出! 姚尧再现春晚同款直播名场面!

中国商务部出手,它们还说“没影响”?

中国商务部出手,它们还说“没影响”?中国商务部出手,它们还说“没影响”?

金鹰卡通《三孩来了 3》:唐九洲谈原生家庭,井胧助力萌娃传递爱意

金鹰卡通《三孩来了 3》:唐九洲谈原生家庭,井胧助力萌娃传递爱意金鹰卡通《三孩来了 3》:唐九洲谈原生家庭,井胧助力萌娃传递爱意

电影《超人》启动#我身边的超人瞬间#线上征集

电影《超人》启动#我身边的超人瞬间#线上征集电影《超人》启动#我身边的超人瞬间#线上征集

华语歌声越南洋|《音你而来2》圆满收官:跨文化传播综艺的新范式

华语歌声越南洋|《音你而来2》圆满收官:跨文化传播综艺的新范式华语歌声越南洋|《音你而来2》圆满收官:跨文化传播综艺的新范式

网易云音乐升级Beat创作者扶持,全免佣金+超高激励金上线

网易云音乐升级Beat创作者扶持,全免佣金+超高激励金上线网易云音乐升级Beat创作者扶持,全免佣金+超高激励金上线

《你行!你上!》姜文新片定档 讲述郎朗和父亲的传奇音乐之旅

《你行!你上!》姜文新片定档 讲述郎朗和父亲的传奇音乐之旅《你行!你上!》姜文新片定档 讲述郎朗和父亲的传奇音乐之旅

爱奇艺《书卷一梦》定档6月26日 李一桐刘宇宁上演穿书流强制爱

爱奇艺《书卷一梦》定档6月26日 李一桐刘宇宁上演穿书流强制爱爱奇艺《书卷一梦》定档6月26日 李一桐刘宇宁上演穿书流强制爱

张哲通《小娘惹之翡翠山》完美收官 深情守护终获圆满

张哲通《小娘惹之翡翠山》完美收官 深情守护终获圆满张哲通《小娘惹之翡翠山》完美收官 深情守护终获圆满