2025-08-26 00:08

2025-08-26 00:00

2025-08-25 23:51

2025-08-25 23:43

2025-08-25 23:15

2025-08-25 23:10

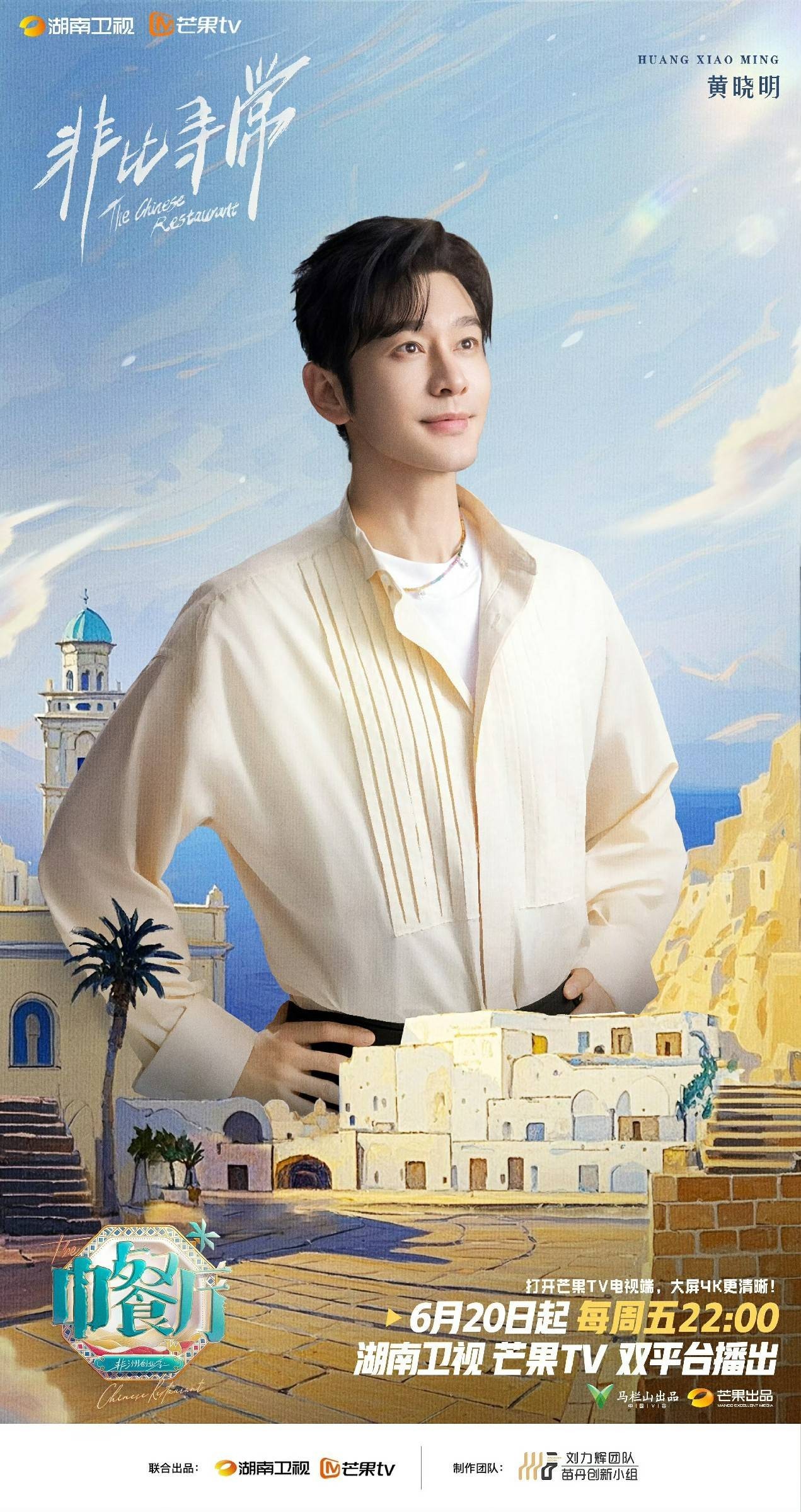

黄晓明率队开启《中餐厅·非洲创业季》新篇章,影视综多面开花诠释全能担当

2025-08-25 23:08

苏见信 (信)「尽兴而活」成都站巡回演唱会圆满收官 苏有朋惊喜助阵引热潮

2025-08-25 22:54

2025-08-25 22:46

2025-08-25 22:43

“歌游内蒙古”北疆文化活动季主题演出 乌兰图雅乐队火力全开 万人合唱嗨翻全场

2025-08-25 22:31

2025-08-25 22:28

2025-08-25 22:16

2025-08-25 22:13

鱼你在一起曼谷首店引爆!POND明星效应+本土化营销打造中餐出海标杆

2025-08-25 22:06

金鹰卡通《三孩来了 3》:唐九洲谈原生家庭,井胧助力萌娃传递爱意

2025-08-25 22:05

2025-08-25 22:05

2025-08-25 22:04

红果短剧出品 金广发自导自演短剧《金先生和他的二十来个乘客》杀青

2025-08-25 22:00

第三届浪潮创作人论坛在京举行,共同探讨AI共创时代的创新音乐叙事

2025-08-25 21:57

英国航空高管:为提振客运需求,希望英国加入中国的30天免签入境计划

2025-08-25 21:55

2025-08-25 21:51

2025-08-25 21:45

2025-08-25 21:41

2025-08-25 21:33

原创话剧《北去·南归》在京首演:简洁样貌与朴素情感“在场”大放异彩

原创话剧《北去·南归》在京首演:简洁样貌与朴素情感“在场”大放异彩原创话剧《北去·南归》在京首演:简洁样貌与朴素情感“在场”大放异彩

热血逆袭+明星顾客+爆笑经营!《微笑一号店》真实展现青年创业的酸甜苦辣咸

热血逆袭+明星顾客+爆笑经营!《微笑一号店》真实展现青年创业的酸甜苦辣咸热血逆袭+明星顾客+爆笑经营!《微笑一号店》真实展现青年创业的酸甜苦辣咸

《书卷一梦》今日开播,李一桐刘宇宁上演穿书流强制爱

《书卷一梦》今日开播,李一桐刘宇宁上演穿书流强制爱《书卷一梦》今日开播,李一桐刘宇宁上演穿书流强制爱

6部超高清大剧亮相上海电视节

6部超高清大剧亮相上海电视节6部超高清大剧亮相上海电视节

非法收受财物2.29亿余元 窦万贵一审被判死缓

非法收受财物2.29亿余元 窦万贵一审被判死缓非法收受财物2.29亿余元 窦万贵一审被判死缓

电影《热血江湖》在浙江丽水开机了由赵天齐领衔主演,还有多名熟脸演员加盟

电影《热血江湖》在浙江丽水开机了由赵天齐领衔主演,还有多名熟脸演员加盟电影《热血江湖》在浙江丽水开机了由赵天齐领衔主演,还有多名熟脸演员加盟

李静、刘璇共话新平衡之约

李静、刘璇共话新平衡之约李静、刘璇共话新平衡之约

对话制片人钟楚渝:揭秘数据分析的影视应用

对话制片人钟楚渝:揭秘数据分析的影视应用对话制片人钟楚渝:揭秘数据分析的影视应用

警惕!“美企竟这样绕过禁令,偷拿中国关键矿物”

警惕!“美企竟这样绕过禁令,偷拿中国关键矿物”警惕!“美企竟这样绕过禁令,偷拿中国关键矿物”

张哲通《小娘惹之翡翠山》完美收官 深情守护终获圆满

张哲通《小娘惹之翡翠山》完美收官 深情守护终获圆满张哲通《小娘惹之翡翠山》完美收官 深情守护终获圆满

爱奇艺国际版将与SBS Studio Prism携手制作泰国版《Running Man》

爱奇艺国际版将与SBS Studio Prism携手制作泰国版《Running Man》爱奇艺国际版将与SBS Studio Prism携手制作泰国版《Running Man》

从上海电视节白玉兰论坛看短剧趋势,听花岛坚持价值思维与题材创新

从上海电视节白玉兰论坛看短剧趋势,听花岛坚持价值思维与题材创新从上海电视节白玉兰论坛看短剧趋势,听花岛坚持价值思维与题材创新